A integração da inteligência artificial no setor jurídico está revolucionando a atuação de advogados, juízes e outros profissionais. No entanto, especialistas[1] da área alertam para um problema grave e crescente: a proliferação de alucinações geradas por IA em documentos jurídicos, um fenômeno que vem ocorrendo em larga escala[2].

Esses episódios revelam um problema sério: embora os modelos de IA prometam economia de tempo, eles frequentemente falham em entregar a precisão e as referências verificáveis que os tribunais tanto dependem. Por enquanto, os erros têm sido detectados. No entanto, não é difícil imaginar um cenário futuro em que uma decisão judicial seja influenciada por informações completamente inventadas pela IA, sem que ninguém perceba.

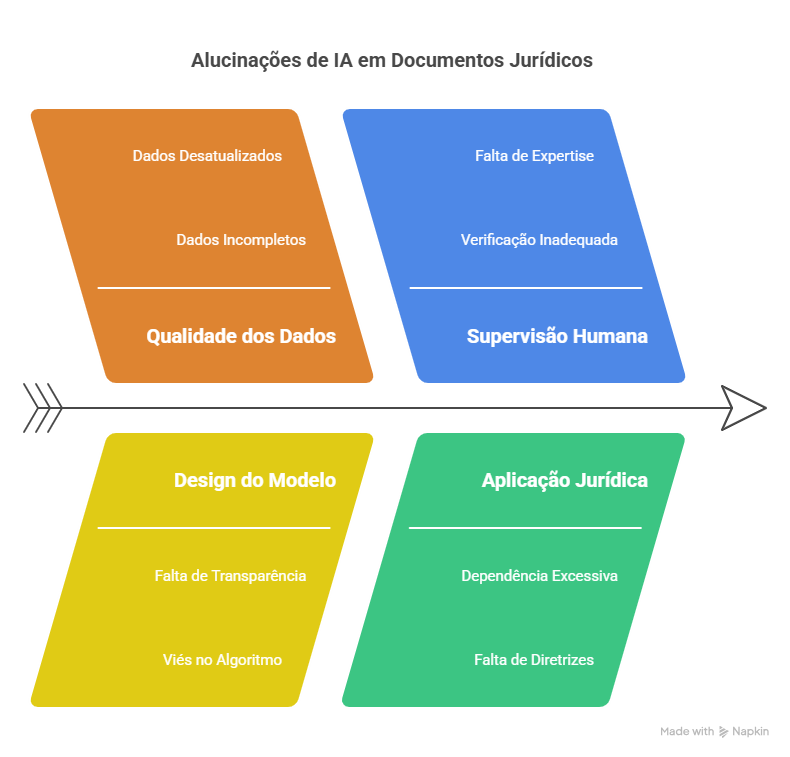

Esta questão transcende a mera discussão técnica sobre limitações tecnológicas, configurando-se como um problema ético e jurídico fundamental que demanda análise criteriosa. A natureza dessas “alucinações”[3] e suas implicações para a segurança jurídica representam desafios inéditos para o sistema de justiça, exigindo uma compreensão aprofundada de suas causas, manifestações e estratégias de mitigação.

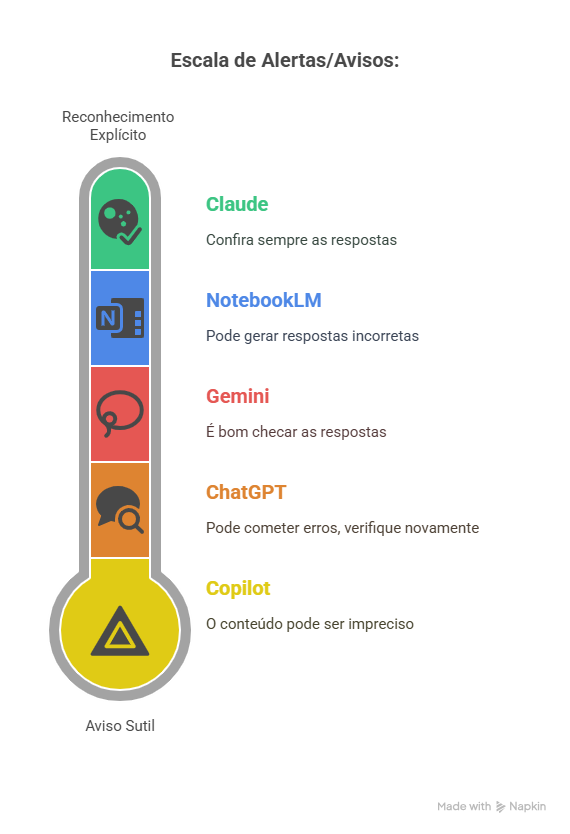

As principais plataformas de inteligência artificial demonstram consciência sobre suas limitações através de avisos explícitos aos usuários. Observa-se uma convergência notável nessas advertências: o Copilot adverte que “o conteúdo gerado por IA pode estar incorreto”; o ChatGPT esclarece que “pode cometer erros” e recomenda verificar informações importantes; o Gemini orienta que “é bom checar as respostas”; o NotebookLM alerta que “pode gerar respostas incorretas” e o Claude aconselha “confira sempre as respostas”, inclusive a Antropic, detentora do Claude, publicou nota em razão de fabricação de provas legais.[4]

As alucinações são uma característica natural dos modelos de linguagem. Este fenômeno não resulta de falha técnica pontual, mas constitui efeito colateral inerente ao funcionamento atual desses sistemas.[5] Isso significa que não podemos confiar cegamente na inteligência artificial. Talvez as empresas que desenvolvem essas tecnologias precisem nos lembrar com mais frequência dessa limitação. Mesmo sabendo que a IA pode errar, muitas pessoas continuam usando sem verificar as informações.

O fato de juristas experientes estarem cometendo erros por confiar na IA mostra como tratamos essa tecnologia: sabemos que ela falha, mas como soa convincente, acabamos acreditando. Com o tempo, esses modelos ganham uma aparência de autoridade e é aí que mora o perigo.

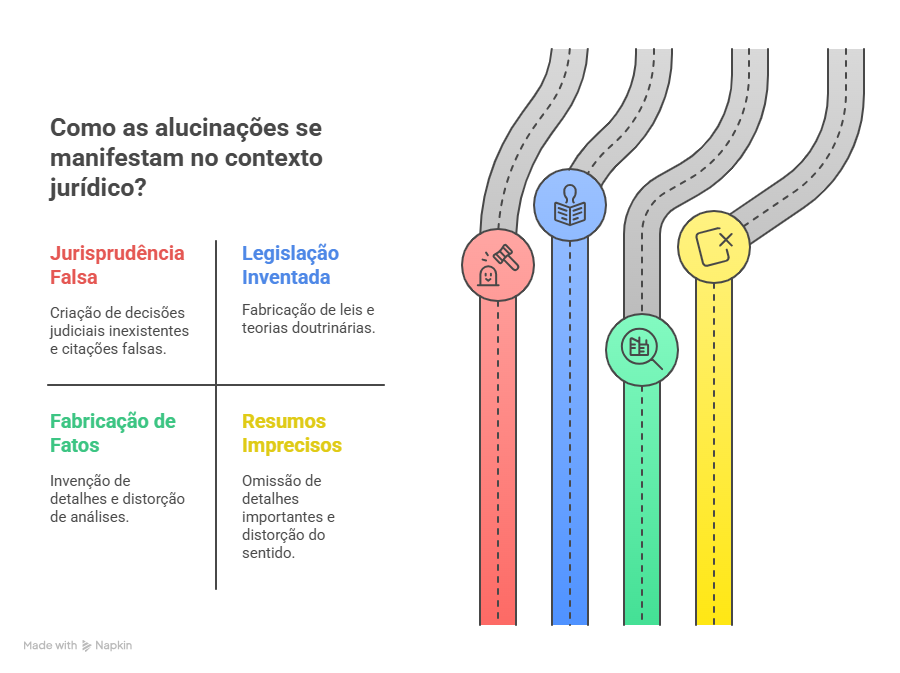

A seguir, destacamos as principais formas como as alucinações se manifestam no contexto jurídico[6]:

- Jurisprudência Falsa

As alucinações mais perigosas no ambiente jurídico manifestam-se através da invenção de decisões judiciais inexistentes, criação de números de processos fictícios, referência a tribunais que não existem e produção de citações que parecem autênticas mas são completamente falsas. Estes erros podem comprometer gravemente a fundamentação de peças processuais e decisões judiciais.

- Legislação e Doutrina Inventadas

Observa-se também a criação de leis inexistentes, distorção do conteúdo de normas reais e elaboração de teorias doutrinárias fictícias. Tais distorções podem induzir profissionais a fundamentar seus argumentos em bases jurídicas inconsistentes.

- Fabricação de Fatos

A IA pode inventar detalhes que não constam nos autos processuais, criar informações não fornecidas pelo usuário e distorcer análises jurídicas, comprometendo a fidedignidade da representação factual.

- Resumos Imprecisos

Mesmo em tarefas aparentemente simples, como elaboração de resumos, podem ocorrer imprecisões factuais, omissão de detalhes importantes e distorção do sentido original dos documentos analisados.

Em tempo: sistemas de IA não compreendem verdadeiramente o significado jurídico do conteúdo que produzem, operando por meio de associações estatísticas complexas sem um entendimento conceitual real. Essa característica gera insegurança jurídica, não por desonestidade intencional do sistema, mas pela ausência de compreensão real do conteúdo produzido. A IA é programada para responder independentemente da correção da informação, a menos que tenha a capacidade de consultar fontes externas confiáveis.[7]

A adoção judicial da inteligência artificial tem encontrado expressão formal em decisões como a observada no TJDFT, que incluiu o seguinte aviso: “Esta decisão foi produzida com auxílio de Inteligência Artificial. Toda a produção da IA foi conferida por ação humana, mas não é possível descartar totalmente a ocorrência de erros considerando o estado inicial da tecnologia.”

Embora tal informação seja opcional, segundo a recente Resolução CNJ nº 615/2025[8], sua inclusão demonstra compromisso com a transparência processual e reconhecimento responsável das limitações tecnológicas atuais.

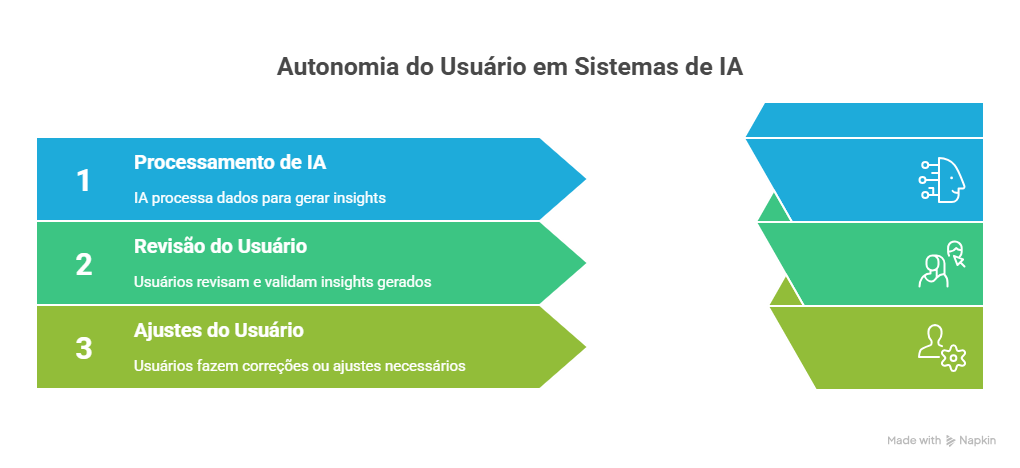

O usuário deve ter plena consciência de que a IA erra de fato, e este reconhecimento não é meramente técnico, mas juridicamente imperativo. A revisão crítica das respostas geradas por sistemas inteligentes configura-se como dever profissional inescapável, especialmente considerando as graves consequências que erros jurídicos podem acarretar para a sociedade e para a segurança das relações jurídicas.

O uso irrefletido da IA, portanto, não gera racionalidade, mas a aparência de racionalidade. No Direito, pode ser ainda mais perigoso do que o erro evidente. A decisão final deve sempre permanecer sob controle humano, preservando a autonomia e responsabilidade profissional dos operadores jurídicos.

Por fim, a centralidade da pessoa humana é um fundamento para qualquer usuário da inteligência artificial, conforme dispõe a referida Resolução[9]. Para evitar riscos, é importante adotar medidas de prevenção, cautela e controle, tanto no uso intencional quanto no não intencional dessas tecnologias. Também é essencial garantir uma supervisão humana contínua e adequada, ajustada ao grau de risco e ao nível de automação da IA.

[1] Instituições precisam de letramento digital em IA para uso no direito

[2] As últimas semanas trouxeram à tona uma série de casos envolvendo o uso de inteligência artificial nos tribunais, com notícias frequentes sobre multas aplicadas por má-fé devido à utilização de jurisprudência inventada.

[3] A alucinação em inteligência artificial configura-se como um defeito técnico no qual o sistema gera conteúdo factualmente incorreto, mas apresentado com aparente precisão e credibilidade.

[4] A Anthropic pede desculpas após o Claude AI fabricar provas legais. (https://www.perplexity.ai/page/anthropic-apologizes-after-cla-HUcL8yq8RwOhKJyv1hXHDA)

[5] A arquitetura contemporânea da IA generativa fundamenta-se na produção de texto plausível através de padrões estatísticos, prevendo a próxima palavra mais provável em uma sequência.

[6] 22.05.25 – 1º Workshop Gratuito – Evitando alucinações: como usar IA com segurança no Direito

[7] Análise da Resolução do CNJ sobre Implementação de IA no Poder Judiciário — Tribunal de Justiça do Distrito Federal e dos Territórios

[8] Art. 33. Os usuários externos deverão ser informados, de maneira clara, acessível e objetiva, sobre a utilização de sistemas baseados em IA nos serviços que lhes forem prestados, devendo ser empregada linguagem simples, que possibilite a fácil compreensão por parte de pessoas não especializadas. § 3º A comunicação sobre o eventual uso da IA no texto de decisões judiciais será uma faculdade de seu signatário, observado o disposto no inciso IV do § 3º e o § 6º do art. 19 desta Resolução. (original1555302025031467d4517244566.pdf)

[9] Art. 2º, IV – da Resolução 615/2025 do CNJ. (original1555302025031467d4517244566.pdf)